前言

在前面的文章中,我們已經把Hadoop安裝起來了,那本篇文章,則是要接續前面的部份,將HBase也一併安裝起來。

前置條件

- 需要完整的安裝並正常運行Hadoop,若還沒完成者,請先到此篇文章進行安裝。

第一步:下載HBase壓縮檔

這邊一樣,我們先使用wget指令下載HBase壓縮檔,下載完成之後,進行解壓縮並把整個檔案移到/usr/local/hbase,並將使用者權限修改為hadoop,相關指令如下。

這裡示範安裝HBase版本為1.4.7

wget http://apache.mirror.gtcomm.net/hbase/stable/hbase-1.4.7-bin.tar.gz tar -zxvf hbase-1.4.7-bin.tar.gz sudo mv hbase-1.4.7 /usr/local/hbase/ sudo chown -R hadoop /usr/local/hbase/

第二步:設定HBase環境變數

依照下面的方式,在~/.bashrc中設定相關的環境變數

export HBASE_HOME=/usr/local/hbase export PATH=$PATH:$HBASE_HOME/bin

設定完成之後,別忘了使用source指令進行重新載入.bashrc檔

第三步:設定hbase-env.sh

在hbase-env.sh設定檔中,設定JAVA_HOME環境變數。相關指令如下:

cd /usr/local/hbase/conf vim hbase-env.sh

並加入這一行:export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

編輯/usr/local/hbase/conf/hbase-site.xml設定檔案並將下列內容加到<configuration></configuration>之間,其內容如下:

<property> <name>hbase.rootdir</name> <value>hdfs://localhost:9000/hbase</value> </property> <property> <name>hbase.zookeeper.property.dataDir</name> <value>/home/hadoop/zookeeper</value> </property> <property> <name>hbase.cluster.distributed</name> <value>true</value> </property>

第四步:執行HBase

使用下面的指令將HBase跑起來。

/usr/local/hbase/bin/start-hbase.sh

一樣,在執行過程中會需要打密碼,那就打hadoop使用者的密碼。

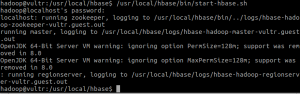

執行成功後如截圖所示:

接著執行HBase shell。

hbase shell

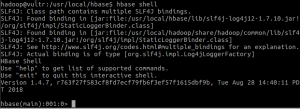

執行成功後如下截圖所示:

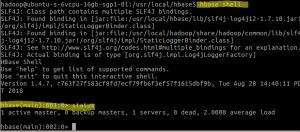

我們可以在HBase shell底下執行status命令來查看有沒有出現錯誤,若成功的話,可以得到下面截圖的結果。

也可以用網頁的方式查看目前HBase的狀態。其拜訪網址如下:

http://ip-address-or-domain-name:16010

總結

啟動HBase執行script順序如下:

start-hdfs.sh start-yarn.sh start-hbase.sh

結束HBase之script順序如下:

stop-hbase.sh stop-dfs.sh stop-yarn.sh

每個script檔案擺放路徑就不在此一一贅述,可以去先前的文章內容中找到相對應的script檔案路徑。

Hadoop + HBase對於硬體資源是很要求的。我在自租的VPS,太差的配備是跑不起來的。

以個人的經驗來說,CPU建議至少要再4core至6core才夠用,RAM大約在16G會比較好一點,我是在DigitalOcean上面跑起來的。選用的方案是6core+16G的Droplet方案。